Linee guida etiche per l’IA: come applicarle per un business affidabile

Data: 1 Settembre 2025Stiamo assistendo a un’accelerazione senza precedenti nello sviluppo delle tecnologie di intelligenza artificiale (AI). La questione dell’etica nell’AI o AI Ethics, sta acquisendo un’importanza sempre maggiore: la necessità di integrare principi etici nella progettazione, sviluppo e implementazione dell’AI nasce per garantire che queste tecnologie siano utilizzate in modo responsabile e con reale beneficio per l’umanità. Molte organizzazioni internazionali e istituzioni accademiche si sono già spese per promuovere un’AI etica, sia di recente sia agli albori di questa tecnologia. Scopriamo come.

I principi fondamentali dell’etica applicata all’IA

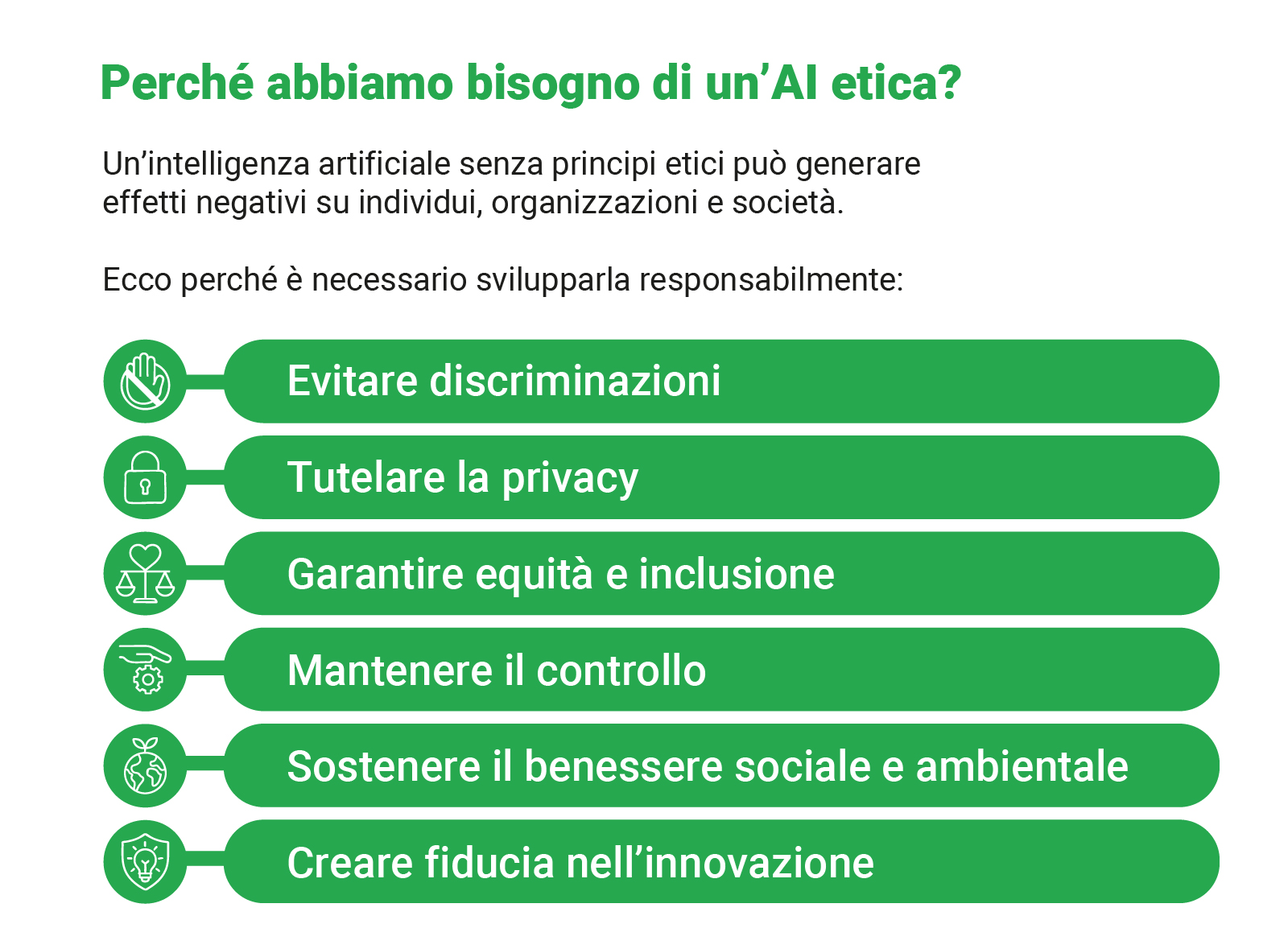

L’etica nell’intelligenza artificiale, o AI Ethics, si occupa delle questioni morali legate allo sviluppo e all’impiego delle tecnologie AI. È un campo interdisciplinare che mira a garantire che le applicazioni basate su intelligenza artificiale siano progettate e utilizzate in modo responsabile, rispettando i diritti umani, la dignità e la diversità.

Questo tema, un tempo considerato puramente filosofico, è oggi una necessità strategica per ogni azienda che utilizza o sviluppa tecnologie AI. L’integrazione di principi etici non solo previene discriminazioni e garantisce trasparenza, ma tutela la reputazione aziendale, rafforza la fiducia dei clienti e assicura la conformità normativa, aspetti cruciali per il successo e la sostenibilità nel mercato attuale.

I principi cardine dell’etica applicata all’IA sono:

- Trasparenza: implica la capacità di comprendere come i sistemi di IA prendono le decisioni. Evitare la “scatola nera” significa rendere i processi decisionali dell’IA intelligibili agli esseri umani. Questo permette di identificare e correggere eventuali errori o bias, costruendo fiducia e facilitando la risoluzione di problemi per le aziende.

- Equità: l’IA deve trattare tutti in modo imparziale, evitando discriminazioni basate su etnia, genere, età o altri fattori. Questo principio è fondamentale per prevenire decisioni ingiuste in ambiti come le assunzioni, l’accesso al credito o la giustizia. Protegge l’azienda da danni reputazionali e legali.

- Responsabilità: definisce chi è responsabile per le azioni e le decisioni prese dai sistemi di IA. Sia gli sviluppatori che gli utilizzatori devono assumersi la responsabilità degli impatti dell’IA, garantendo meccanismi di supervisione e di rendicontazione. Questo crea un quadro di fiducia e affidabilità.

- Privacy: l’IA spesso elabora grandi volumi di dati personali. Il rispetto della privacy significa implementare robuste misure di protezione dei dati, garantire il consenso informato e aderire a normative come il GDPR. Proteggere i dati dei clienti e dei dipendenti è essenziale per mantenere la fiducia e evitare sanzioni.

Integrare questi principi è fondamentale per lo sviluppo e l’adozione dell’AI, anche per le AI per pmi. Questo assicura che il progresso tecnologico vada di pari passo con un impatto sociale positivo e un business affidabile.

I 7 requisiti europei per un’intelligenza artificiale affidabile

L’Unione Europea ha introdotto, già nel 2019, le Ethics Guidelines for Trustworthy AI, un quadro pratico di riferimento per lo sviluppo e l’uso di un’IA affidabile. Queste linee guida identificano sette requisiti essenziali che le aziende che operano in Europa devono conoscere e applicare per garantire un’innovazione responsabile e conforme.

Ecco i sette pilastri per un’intelligenza artificiale affidabile:

- Supervisione umana: mantenere il controllo umano sulle macchine è fondamentale per garantire che le decisioni siano responsabili e, se necessario, reversibili. Questo assicura che l’IA sia un supporto, non un sostituto del giudizio umano, specialmente in ambiti critici.

- Robustezza e sicurezza: è vitale sviluppare sistemi IA sicuri, affidabili e resilienti agli attacchi. Devono essere capaci di gestire errori in modo efficace, proteggendo l’azienda da malfunzionamenti e vulnerabilità.

- Privacy e governance dei dati: proteggere la privacy e gestire adeguatamente i dati è imprescindibile. Ciò include garantire la qualità, l’integrità e la sicurezza delle informazioni utilizzate dall’IA, in linea con normative come il GDPR.

- Trasparenza: i processi e le decisioni dell’IA devono essere chiari e tracciabili per favorire la loro comprensione e la fiducia. Questo permette all’azienda di spiegare come un’IA è giunta a un certo risultato, essenziale per la responsabilità e la risoluzione di controversie.

- Diversità, non discriminazione e equità: deve promuovere l’inclusione e prevenire bias e discriminazioni all’interno dei sistemi IA. Garantire equità e accessibilità significa che l’IA deve beneficiare tutti, senza replicare o amplificare pregiudizi esistenti.

- Benessere sociale e ambientale: l’IA deve contribuire positivamente al benessere della società, all’economia e alla sostenibilità ambientale. Le aziende sono chiamate a considerare l’impatto complessivo delle loro soluzioni AI sulla comunità e sul pianeta.

- Responsabilità: implementare meccanismi di accountability per le decisioni dell’IA è necessario, con criteri chiari e possibilità di ricorso. Questo assicura che ci sia sempre qualcuno responsabile degli impatti dell’IA, tutelando sia l’azienda che gli individui.

L’obiettivo è garantire che i sistemi di IA operino in modo trasparente e senza causare danni, rispettando i diritti fondamentali e operando con meccanismi di accountability. La Commissione Europea promuove un approccio che bilancia l’innovazione tecnologica con la protezione dei valori e dei diritti fondamentali.

Come integrare l’etica AI: le best practice per la tua azienda

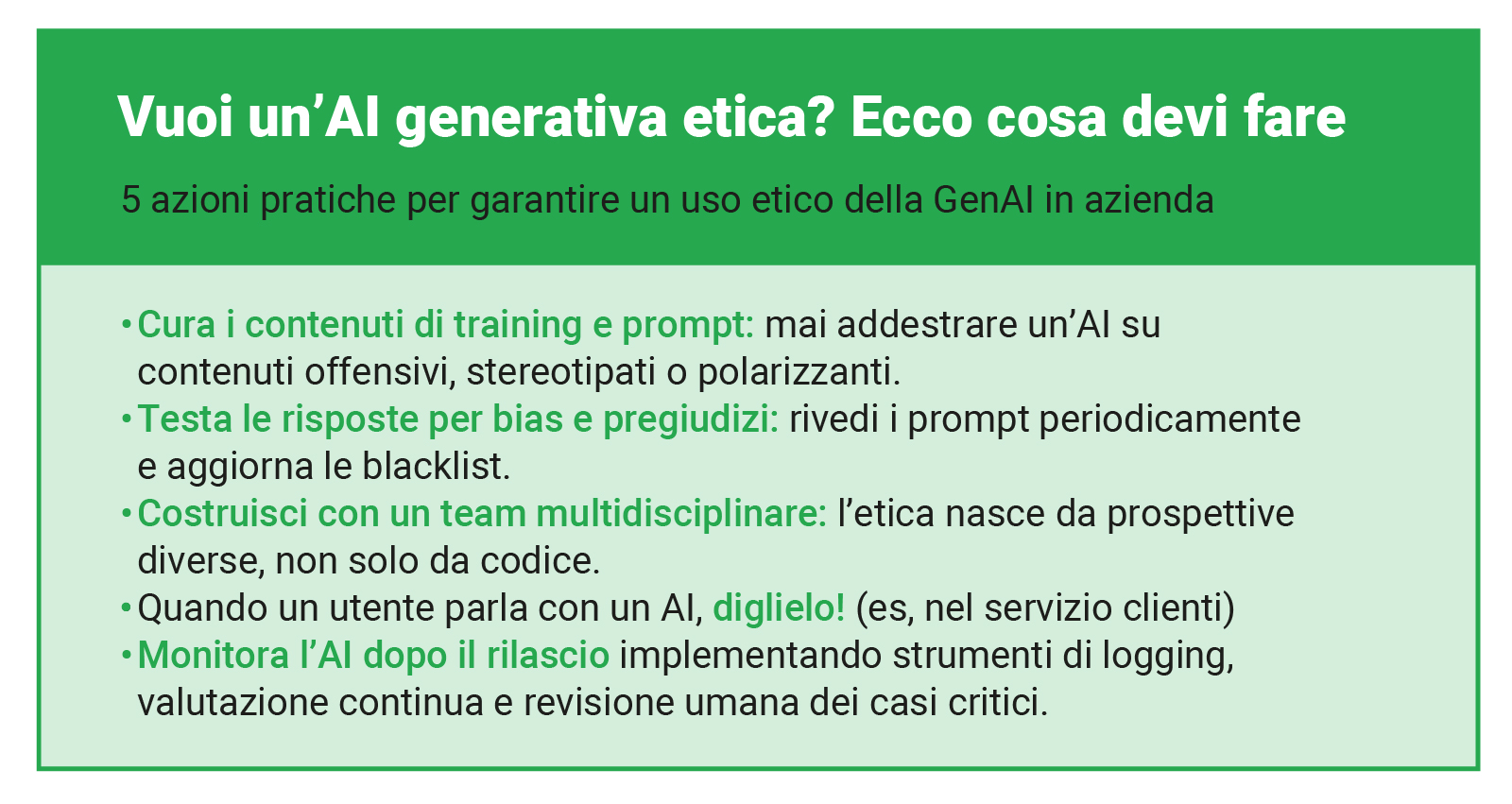

Integrare l’etica nel ciclo di vita dell’intelligenza artificiale non è solo una questione di conformità, ma una strategia che rafforza la fiducia, migliora la reputazione e garantisce l’adozione responsabile dell’IA. Per la tua azienda, questo si traduce in azioni concrete e proattive da implementare fin dalle prime fasi di sviluppo e utilizzo.

Ecco alcune best practice fondamentali per integrare l’etica AI nel tuo business:

- Stabilire un comitato etico interno o un responsabile di riferimento: creare un team o designare una figura dedicata all’etica dell’IA assicura una supervisione costante. Questo organismo può valutare i rischi, definire le policy interne e fungere da punto di riferimento per dubbi e questioni etiche.

- Condurre valutazioni d’impatto etico (EIA) prima di lanciare nuovi progetti AI: analogamente alle valutazioni d’impatto sulla privacy, un EIA permette di identificare e mitigare preventivamente i potenziali rischi etici (come bias o impatti sociali negativi) di una nuova soluzione AI, prima che questa venga implementata.

- Formare i team di sviluppo e chi utilizza l’IA sui principi etici: la conoscenza è potere. Assicurare che tutti i professionisti coinvolti, dagli sviluppatori agli utenti finali, comprendano i principi etici dell’IA e come applicarli nel loro lavoro quotidiano è essenziale per un’adozione responsabile e consapevole.

- Creare team di sviluppo diversificati per ridurre i bias inconsci: i bias negli algoritmi spesso nascono dai bias presenti nei dati o nei team di sviluppo. Promuovere la diversità (di genere, etnia, background) nei team che progettano l’IA aiuta a identificare e correggere i pregiudizi prima che si manifestino nei sistemi.

Adottare queste pratiche permette di approcciare le sfide dell’AI nel mondo del lavoro con una visione lungimirante, costruendo un futuro in cui l’IA è uno strumento al servizio dell’uomo, gestito con consapevolezza e responsabilità.

I rischi etici concreti: dai bias nei dati alla privacy dei clienti

L’adozione dell’intelligenza artificiale, se non gestita con attenzione e una solida etica, può esporre le aziende a rischi concreti e tangibili. Questi rischi vanno oltre le preoccupazioni teoriche e possono avere un impatto diretto sulla reputazione, sulla conformità normativa e sulla relazione con clienti e dipendenti. Conoscere i rischi che possono derivare da un’adozione non “guidata” da principi etici è importante per poterle prevenire.

Vediamo alcuni scenari pratici di rischi etici legati all’IA:

Bias nei dati e discriminazione algoritmica

Immagina un algoritmo di recruiting progettato per velocizzare la selezione dei candidati. Se questo algoritmo viene addestrato su dati storici che riflettono pregiudizi inconsci presenti nelle assunzioni passate (ad esempio, favorendo un genere o un’etnia rispetto a un’altra per determinate posizioni), il sistema di IA potrebbe replicare e addirittura amplificare queste discriminazioni.

Ciò potrebbe portare a scartare candidati qualificati ingiustamente, causando non solo un danno alla reputazione dell’azienda, ma anche ripercussioni legali e un impoverimento della diversità aziendale.

Violazione della privacy e della fiducia del cliente

Considera un chatbot di assistenza clienti, addestrato per gestire richieste complesse, inclusi dati sensibili degli utenti. Se questo chatbot non è progettato con rigidi protocolli di sicurezza e privacy, o se gestisce male le informazioni confidenziali, si rischia la violazione della fiducia del cliente.

Ad esempio, potrebbe esporre involontariamente dati personali, non rispettare le preferenze di consenso o non cancellare le informazioni come richiesto, portando a gravi violazioni del GDPR e a una perdita irreparabile della fiducia del cliente.

Questi esempi sottolineano come la superficialità nell’approccio etico all’IA non sia solo un problema morale, ma una minaccia diretta alla stabilità e alla credibilità del business.

Un’IA etica come vantaggio competitivo per il futuro

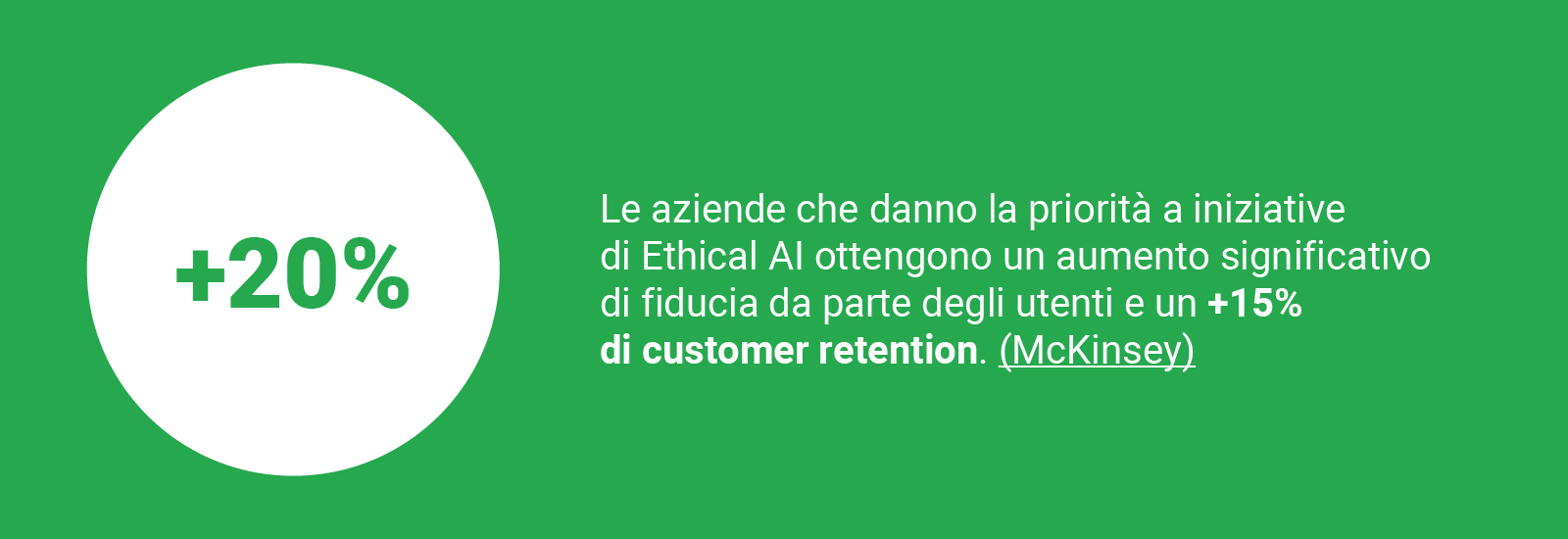

L’idea di adottare un approccio etico all’intelligenza artificiale va ben oltre la necessità di essere conformi alla normativa: l’IA può infatti rappresentare un potente vantaggio competitivo per il futuro della tua azienda. Integrare l’etica nella progettazione e nell’uso dell’IA significa costruire un modello di business più robusto, credibile e attraente sul mercato.

I benefici di business derivanti da un approccio etico sono concreti:

- Miglioramento della brand reputation: un’azienda riconosciuta per l’uso responsabile e trasparente dell’IA rafforza la propria immagine e reputazione. Essere pionieri in un’IA equa e sicura posiziona il brand come leader innovativo e affidabile.

- Aumento della fiducia e della lealtà dei clienti: quando i clienti percepiscono che i loro dati sono trattati con etica e che le decisioni basate sull’IA sono giuste e trasparenti, la loro fiducia aumenta. Questo si traduce in una maggiore lealtà, riducendo l’abbandono e favorendo relazioni durature.

- Attrazione dei migliori talenti: le nuove generazioni di professionisti, in particolare quelli nel settore tecnologico, sono sempre più attente ai valori aziendali. Un impegno chiaro verso l’etica nell’IA rende la tua azienda un datore di lavoro più attraente per i talenti più qualificati, desiderosi di contribuire a un’innovazione con uno scopo.

Un approccio etico non è un freno all’innovazione, ma un vero e proprio acceleratore. Spinge le aziende a sviluppare soluzioni IA prive di bias e pensate per avere un impatto positivo. Questo non solo può rappresentare un volano per uno sviluppo sostenibile, ma può aiutare l’azienda a creare un forte differenziatore sul mercato.

L’etica diventa un elemento distintivo, permettendo all’azienda di spiccare in un panorama competitivo sempre più affollato e di anticipare le future esigenze di un mercato sempre più consapevole e regolamentato.

Primi passi per definire un framework etico nella tua PMI

Definire un framework etico per l’intelligenza artificiale può sembrare un compito complesso, specialmente per una PMI che non ha strutture dedicate. Nonostante ciò, si tratta di un passaggio fondamentale per un’adozione responsabile e sostenibile di questa tecnologia.

Non è necessario partire con una struttura complessa; bastano pochi, chiari, primi passi per costruire le basi di un approccio etico strategico.

Ecco una mini-guida che abbiamo pensato per avviare la tua azienda in questo percorso:

- Mappare gli utilizzi attuali e futuri dell’IA in azienda: inizia identificando dove l’IA è già in uso nella tua PMI, anche in modo informale, e dove prevedi di implementarla in futuro. Comprendere gli scenari d’uso specifici (ad esempio, per il customer service, l’analisi dati, la marketing automation) è il primo passo per individuare i potenziali rischi etici e le aree che richiedono maggiore attenzione.

- Coinvolgere un team multidisciplinare: l’etica dell’IA non è solo una questione tecnica. Riunisci un piccolo team che includa diverse competenze: chi si occupa di IT, un rappresentante delle Risorse Umane, qualcuno dal reparto legale o compliance (se presente), e un membro del management. Questa diversità di prospettive è cruciale per una visione olistica.

- Definire 3-4 principi etici non negoziabili per la propria realtà: basandoti sulle linee guida generali (trasparenza, equità, responsabilità, privacy), seleziona i principi più rilevanti e critici per la tua specifica attività e i tuoi valori aziendali. Questi diventeranno i pilastri su cui fonderai ogni decisione relativa all’IA.

- Comunicare l’impegno all’interno e all’esterno dell’azienda: una volta definiti i principi e le prime azioni, comunica apertamente questo impegno. All’interno, informa i dipendenti sul perché l’etica è importante e come influirà sul loro lavoro. All’esterno, rendi noto ai tuoi clienti e partner il tuo approccio responsabile all’IA. Questo rafforza la fiducia e la tua reputazione.

Questi primi passi, seppur semplici, costruiscono una base solida per integrare l’etica nell’IA, permettendo alla tua PMI di innovare in modo consapevole e responsabile.

Domande frequenti (FAQ) sull’etica AI in ambito aziendale

L’integrazione dell’intelligenza artificiale solleva spesso interrogativi importanti, specialmente riguardo all’etica e alla responsabilità. Qui rispondiamo alle domande più comuni che riceviamo dai nostri partner.

Da dove inizio per rendere la mia azienda conforme all’etica AI?

Per iniziare a rendere la tua azienda conforme all’etica AI, il primo passo è mappare l’attuale e futuro utilizzo dell’IA all’interno della tua organizzazione. Poi, coinvolgi un team multidisciplinare (IT, HR, legale, management) per definire 3-4 principi etici non negoziabili specifici per la tua realtà. Infine, comunica questo impegno sia internamente che esternamente, per costruire una cultura di trasparenza e responsabilità.

Implementare un’AI etica ha un costo elevato per una PMI?

Implementare un’AI etica non deve necessariamente comportare costi elevati, specialmente per le PMI. Sebbene ci siano investimenti iniziali in formazione e possibile consulenza, un approccio graduale con progetti pilota e l’adozione di best practice può mantenere i costi sotto controllo. I benefici a lungo termine, come il miglioramento della reputazione, la fiducia dei clienti e la riduzione dei rischi legali, superano ampiamente l’investimento, rendendolo un vantaggio competitivo.

Chi è responsabile in azienda se l’IA commette un errore?

La responsabilità per gli errori commessi da un sistema di IA ricade sempre sull’essere umano: sul “deployer” (l’azienda che utilizza l’IA) e/o sul “provider” (chi sviluppa e fornisce l’IA). L’AI Act europeo enfatizza il requisito della supervisione umana e la responsabilità dei soggetti coinvolti, assicurando che non ci sia un vuoto di accountability quando un algoritmo prende decisioni.

L’AI Act europeo e le linee guida etiche sono la stessa cosa?

No, non sono la stessa cosa, ma sono strettamente correlate. Le linee guida etiche (come quelle della Commissione Europea o dell’UNESCO) sono raccomandazioni e principi volontari per lo sviluppo e l’uso responsabile dell’IA. L’AI Act, invece, è un regolamento europeo con valore legale vincolante. Stabilisce obblighi specifici e sanzioni per la non conformità, specialmente per i sistemi di IA ad alto rischio. Le linee guida etiche servono spesso da base o riferimento per comprendere e applicare i requisiti legali dell’AI Act.