AI ethics: quali sono le linee guida per un’intelligenza “etica”

Data: 28 Febbraio 2024Nel contesto attuale, caratterizzato da un’accelerazione senza precedenti nello sviluppo delle tecnologie di intelligenza artificiale (AI), la questione dell’etica nell’AI o AI Ethics, assume un’importanza cruciale. La necessità di integrare principi etici nella progettazione, sviluppo e implementazione dell’AI è diventata un imperativo per garantire che queste tecnologie siano utilizzate in modo responsabile e con reale beneficio per l’umanità. Molte organizzazioni internazionali e istituzioni accademiche si sono già spese per promuovere un’AI etica, sia di recente sia agli albori di questa tecnologia. Scopriamo come

AI Ethics: fondamenti e raccomandazioni UNESCO

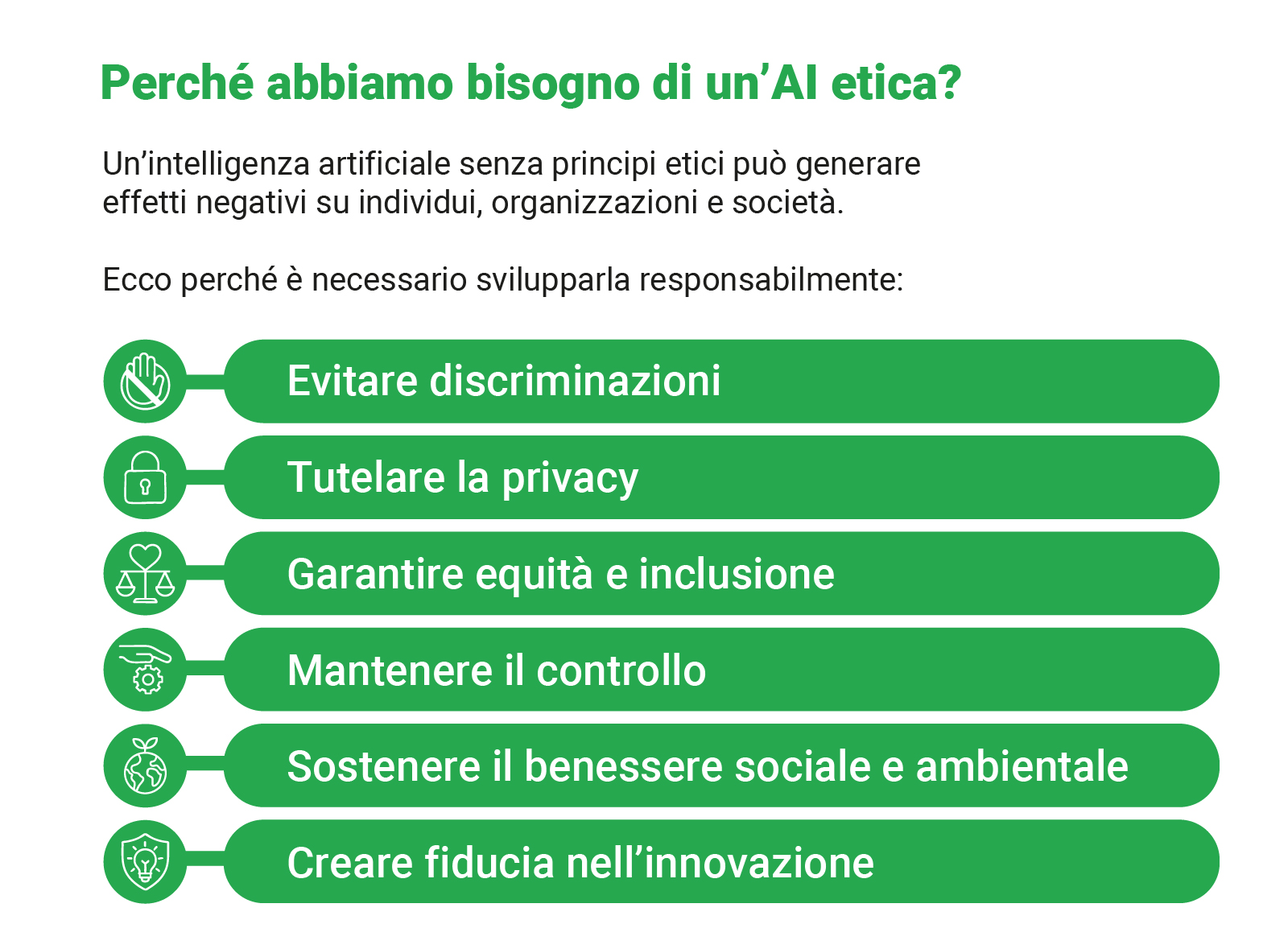

L’etica nell’intelligenza artificiale – AI Ethics – si occupa di questioni morali legate allo sviluppo e all’impiego delle tecnologie AI. Un campo interdisciplinare che si concentra principalmente sull’assicurare che le applicazioni basate su intelligenza artificiale siano progettate e utilizzate in modo responsabile, rispettando i diritti umani, la dignità e la diversità. L’importanza dell’etica nell’AI emerge dalla capacità di queste tecnologie di influenzare profondamente aspetti della vita quotidiana, dall’occupazione alla privacy, dalla sicurezza alla giustizia sociale. Pertanto, integrare principi etici nello sviluppo dell’AI è fondamentale per prevenire discriminazioni, garantire la trasparenza delle decisioni automatizzate e promuovere un impatto positivo sulla società.

L’UNESCO ha pubblicato una serie di raccomandazioni che mirano a orientare i governi e gli sviluppatori nell’adozione di pratiche etiche nell’AI. Queste raccomandazioni enfatizzano l’importanza di principi quali trasparenza, equità, responsabilità e rispetto per la privacy. L’UNESCO sottolinea, inoltre, la necessità di promuovere l’AI per lo sviluppo sostenibile, incoraggiando l’uso di tecnologie che supportino gli obiettivi delle Nazioni Unite in questo senso.

Un aspetto chiave è l’istituzione di meccanismi di governance dell’AI che includano la partecipazione pubblica e la valutazione dell’impatto sociale ed etico delle applicazioni basate su intelligenza artificiale.

Linee guida dell’Unione Europea per un’AI affidabile

L’Unione Europea ha introdotto già nel 2019, prima che il tema raggiungesse le luci della ribalta che sta conoscendo oggi, le Ethics Guidelines for Trustworthy AI, che definiscono un quadro per lo sviluppo e l’uso di un’AI affidabile. Queste linee guida identificano sette requisiti essenziali:

- Supervisione Umana: mantenimento del controllo umano sulle macchine per garantire decisioni reversibili e responsabili.

- Robustezza e sicurezza: sviluppo di sistemi AI sicuri, affidabili e robusti, capaci di gestire errori in modo efficace.

- Privacy e governance dei dati: protezione della privacy e gestione adeguata dei dati, assicurando la loro qualità e integrità.

- Trasparenza: chiarezza nei processi e nelle decisioni AI, con tracciabilità delle azioni per comprensibilità e fiducia.

- Diversità, non discriminazione e equità: promozione dell’inclusione e prevenzione di bias e discriminazioni, garantendo equità e accessibilità.

- Benessere sociale ed ambientale: contributo positivo al benessere sociale, economico e alla sostenibilità ambientale.

- Responsabilità: implementazione di meccanismi di accountability per le decisioni ai, con criteri chiari e possibilità di ricorso.

L’obiettivo è garantire che i sistemi di AI operino in modo trasparente e senza causare danni, rispettando i diritti fondamentali e operando con meccanismi di accountability. La Commissione Europea promuove un approccio che bilancia l’innovazione tecnologica con la protezione dei valori e dei diritti fondamentali.

Sfide e prospettive future nell’AI Ethics

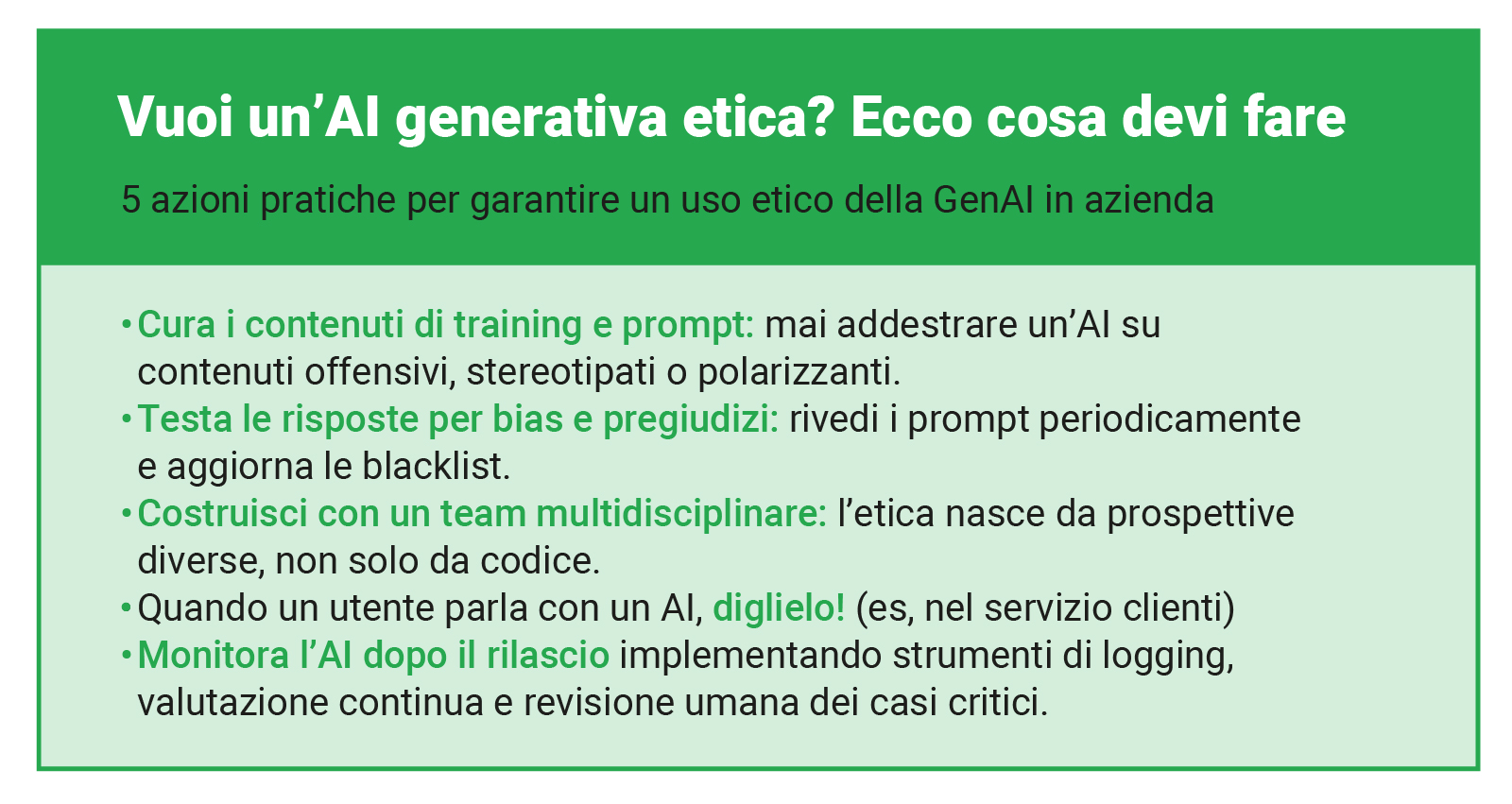

Secondo un articolo pubblicato su Harvard Business Review, per costruire un’AI etica è fondamentale adottare strategie pratiche che vanno oltre i principi teorici. Questo include la promozione della diversità e dell’inclusione all’interno dei team di sviluppo AI, per prevenire bias e discriminazioni nei sistemi e nell’addestramento. È inoltre essenziale stabilire processi di audit etici che valutino regolarmente l’impatto sociale e morale delle applicazioni. Un altro aspetto chiave è l’adozione di un design centrato sull’utente, che tenga conto delle esigenze, dei valori e dei diritti degli individui interessati dalle tecnologie AI.

Nonostante i progressi nelle linee guida e nelle raccomandazioni per un’AI etica, permangono sfide significative. Tra queste, la difficoltà di applicare principi etici universali in contesti diversi e la tensione tra il rapido avanzamento tecnologico e la capacità delle normative di tenere il passo. Guardando al futuro, è probabile che l’AI Ethics giocherà un ruolo sempre più centrale nel dibattito pubblico e nella politica tecnologica, con un’enfasi crescente sulla co-creazione di standard etici tra stakeholder diversi e sulla promozione di un’innovazione responsabile.

AI Ethics, una necessità per il futuro

L’integrazione dell’etica nell’intelligenza artificiale rappresenta una sfida complessa ma indispensabile per garantire che le tecnologie AI siano utilizzate in modo responsabile e benefico. Le raccomandazioni dell’UNESCO, le linee guida dell’Unione Europea e le strategie pratiche proposte da esperti del settore offrono un punto di partenza solido per orientare lo sviluppo di un’AI che sia non solo tecnologicamente avanzata, ma anche eticamente responsabile. Affrontare le sfide attuali e future richiederà un impegno congiunto da parte di sviluppatori, mondo della politica, accademici e società civile, con l’obiettivo comune di costruire un futuro in cui l’AI agisca a beneficio di tutta l’umanità.